Deep Learning e Asset Allocation: una guida per un'allocazione tattica

Introduzione

Il sistema finanziario moderno sta attraversando una trasformazione profonda. In un contesto in cui flussi di dati, notizie e segnali di mercato sono sempre più complessi, la tecnologia diventa uno strumento indispensabile per gestire il capitale. L’Intelligenza Artificiale (IA) in particolare ha aumentato la capacità di elaborare informazioni, riconoscere pattern e prevedere scenari, ma comporta anche nuovi rischi e sfide. La Banca Centrale Europea (BCE) sottolinea che l’emergere di strumenti di intelligenza artificiale generativa costituisce un salto tecnologico con impatti potenzialmente significativi sul sistema finanziario: l’IA porta benefici e rischi, e la sua diffusione comporta problematiche legate ai dati, allo sviluppo e all’impiego dei modelli; un’adozione concentrata potrebbe amplificare il rischio operativo, la concentrazione di mercato e comportamenti imitativi, richiedendo possibili iniziative regolamentari mirate [1].

Per i consulenti finanziari è quindi fondamentale comprendere sia le opportunità sia i limiti di queste tecnologie e saperle raccontare ai clienti. In questo articolo ripercorriamo i concetti di Deep Learning (DL) e ne illustriamo l’applicazione in un modello proprietario di allocazione tattica, evidenziandone i punti di forza rispetto ai metodi tradizionali di Machine Learning (ML) e i requisiti di governance.

Cos’è il Deep Learning

Il Deep Learning è una branca del Machine Learning basata su reti neurali profonde che, grazie a numerosi strati di elaborazione non lineare, riescono a catturare relazioni complesse nei dati. A differenza degli algoritmi ML tradizionali (come regressioni lineari, alberi decisionali o SVM) che necessitano di un’intensa attività di feature engineering e spesso faticano a modellare strutture temporali, le reti neurali possono elaborare direttamente sequenze e grandi quantità di variabili. Una recente rassegna accademica evidenzia che il DL consente di ottimizzare un portafoglio direttamente o replicare un indice con un numero ridotto di asset; l’IA produce stime migliori di rendimento e rischio e risolve problemi di ottimizzazione in presenza di vincoli complessi [2]. Tuttavia, la stessa fonte sottolinea che i modelli basati su IA sono spesso “black box”: l’assenza di trasparenza genera sfide di interpretabilità per investitori e regolatori [3].

Nel campo della previsione di serie temporali, gli algoritmi di DL mostrano performance superiori rispetto ai modelli statistici classici. Ad esempio, gli approcci tradizionali come ARIMA sono stati superati con largo margine dai modelli Long Short-Term Memory (LSTM); altre architetture – come le Gated Recurrent Unit (GRU), i modelli Seq2Seq e le reti neurali convoluzionali (CNN) – continuano a ottenere risultati all’avanguardia nella previsione dei mercati [4]. Questi progressi derivano dalla capacità delle reti neurali di cogliere dipendenze non lineari e dinamiche tra variabili finanziarie, andando oltre la media-varianza della teoria di Markowitz.

Contesto normativo e gestione del rischio

L’introduzione di modelli basati su IA richiede un adeguato framework di model risk management. Il documento di discussione del Prudential Regulation Authority (PRA) del Regno Unito evidenzia che la gestione del rischio modello è sempre più importante per mitigare i rischi legati all’uso dell’IA: l’attuale normativa britannica offre regole solo per modelli di capitale o stress test, senza riferimenti espliciti alla IA e alla spiegabilità dei modelli [5]. Il PRA propone di introdurre principi di governo specifici per tutte le fasi del ciclo di vita del modello – identificazione e classificazione dei modelli, governance, sviluppo, validazione indipendente e misure di mitigazione – applicabili anche ai modelli IA [6]. In parallelo, la BCE ricorda che un’adozione estesa dell’IA da parte di pochi fornitori può accrescere i rischi sistemici: maggiore concentrazione, fragilità operativa e comportamenti di emulazione [1]. Per gli operatori è quindi essenziale adottare procedure di validazione, spiegabilità e “kill switch” per fermare algoritmi che si comportano in modo anomalo.

Il modello di Deep Learning per l’allocazione tattica

Dati e preparazione

Il modello proprietario illustrato in questo articolo nasce con l’obiettivo di ottenere apprezzamento del capitale attraverso una gestione tattica multi-asset. Il portafoglio considera otto ETF liquidi appartenenti a diverse asset class (oro, utilities, consumi discrezionali, energia, beni di consumo di base, tecnologia, titoli di Stato USA a lunga scadenza, sanità). I dati utilizzati spaziano dal febbraio 2006 al febbraio 2025. Per l’addestramento del modello si è adottato un approccio walk-forward: il periodo fino al febbraio 2020 è utilizzato per l’apprendimento, mentre gli anni successivi (incluso l’episodio della pandemia) rappresentano un out-of-sample per valutare la capacità di adattamento del modello.

La fase di data gathering comprende l’allineamento temporale degli asset, l’integrazione di indicatori macroeconomici con ritardi realistici, e l’aggiunta di indicatori tecnici (RSI, MACD, medie mobili, ecc.). Le variabili numeriche vengono confrontate con un benchmark (l’ETF S&P 500 – SPY) per fornire una misura della performance relativa. A questa base dati si aggiungono variabili stagionali per catturare cicli di mercato. I dati sono normalizzati e trasformati in sequenze temporali con 71 caratteristiche per ciascun asset.

Architettura e metodologia

- Layer LSTM: modellano la dipendenza temporale dei rendimenti finanziari, catturando pattern a lungo termine.

- Layer convoluzionali con meccanismo di attenzione: evidenziano relazioni tra asset e pesano dinamicamente le informazioni più rilevanti.

- Dropout e Batch Normalization: migliorano la generalizzazione e la stabilità dell’addestramento.

- Strato d’uscita Softmax: restituisce un vettore di pesi (allocazione) sulle otto asset class.

Un elemento chiave è la funzione di perdita finanziaria. Oltre alla classica ottimizzazione degli errori, la loss include componenti che massimizzano il rapporto di Sharpe, penalizzano la concentrazione di portafoglio tramite un termine di entropia e premiano l’extra-rendimento rispetto al benchmark. Questo consente di allineare l’apprendimento a metriche care agli investitori. L’addestramento è iterativo: per ogni finestra temporale si addestra il modello sui dati disponibili e lo si valida su dati successivi. L’uso del walk-forward riduce l’overfitting, perché il modello non vede mai contemporaneamente passato e futuro.

Risultati addestramento

Il modello è stato addestrato su dati da febbraio 2006 a febbraio 2020, escludendo deliberatamente la crisi COVID-19 per valutare la reale capacità di adattamento out-of-sample. Nonostante ciò, il modello ha mostrato un’elevata resilienza, regolando dinamicamente le allocazioni durante il periodo pandemico e minimizzando i drawdown.

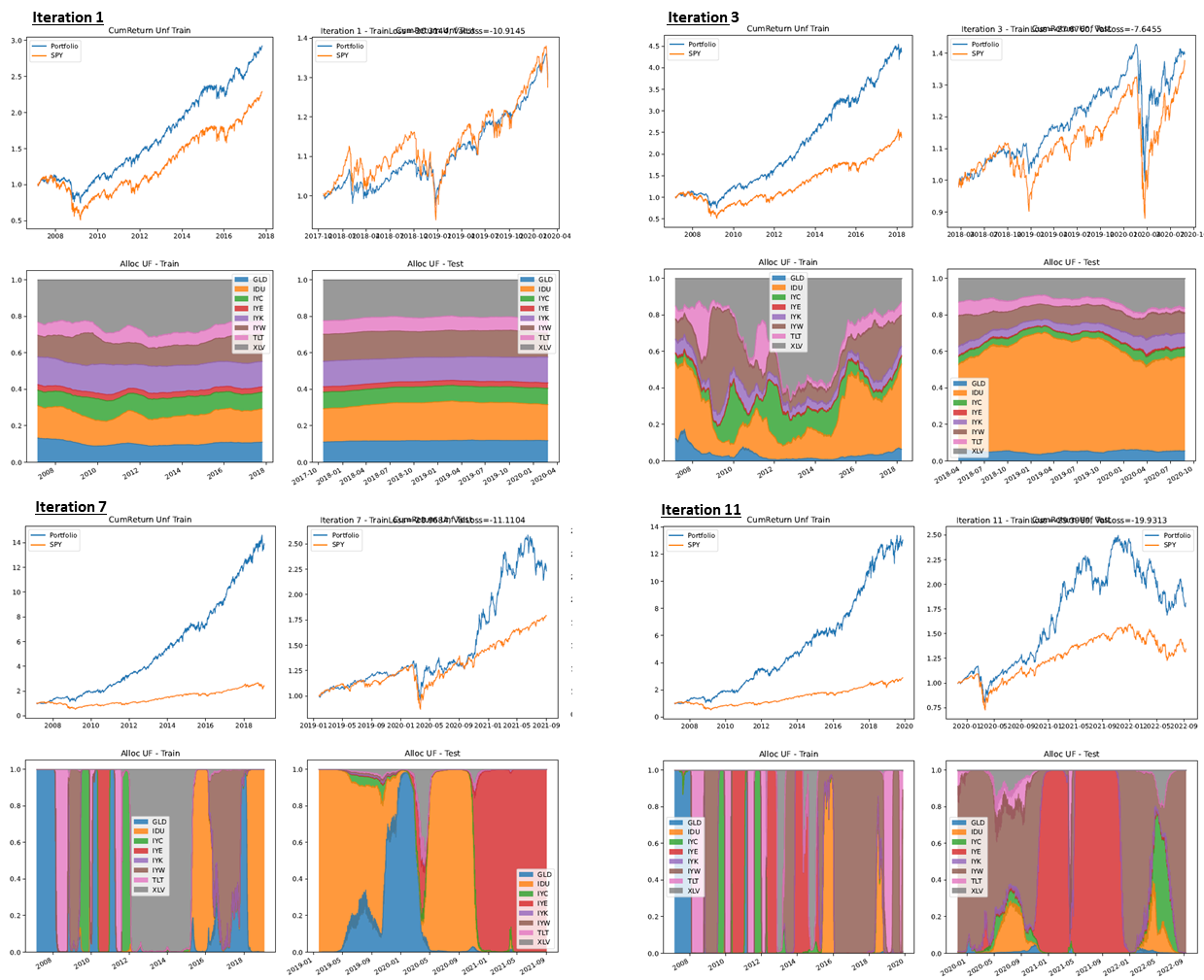

Le figure seguenti illustrano il comportamento del modello al variare delle epoche di training, evidenziando i miglioramenti del delta di rendimento rispetto al benchmark e la maggiore robustezza ottenuta tramite adattamento walk-forward. Questi snapshot esemplificano la capacità del modello di apprendere da condizioni di mercato in evoluzione e di affinare le allocazioni di conseguenza.

L’evoluzione per epoche mostra un chiaro processo di “apprendimento allocativo”. Nelle prime iterazioni il portafoglio mantiene una composizione più diversificata e stabile, con un delta di allocazione contenuto tra gli ETF: i pesi variano lentamente e il modello tende a distribuire il rischio su più asset (equity settoriale, TLT e GLD). In questa fase il ritorno cumulato supera già lo SPY, ma il vantaggio è ancora moderato: l’alpha deriva soprattutto da una migliore diversificazione e da un’esposizione più ordinata ai trend.

Avanzando di epoca, il modello “impara” regimi e transizioni: il delta di allocazione aumenta, compaiono rotazioni più nette e periodi di concentrazione selettiva sui segmenti con momentum o carry più favorevole (ad es. sovrappeso su tecnologia/consumi in bull market; riallocazioni verso TLT/GLD nelle fasi di stress - vedi crisi 2008). Queste scelte più decise si riflettono in equity curve via via più ripide sia in training sia in test, con un gap crescente sul benchmark: il portafoglio non solo partecipa ai rialzi, ma evita con maggiore prontezza i drawdown dei listini, migliorando il profilo rischio/rendimento.

Nelle ultime epoche la dinamica diventa ancora più evidente: le bande di allocazione mostrano blocchi compatti (regime switching), segno di una maggiore confidenza statistica del modello nel selezionare i driver di performance del periodo. L’aumento del ritorno cumulato è la conseguenza diretta di tre fattori: (i) timing più rapido nelle transizioni di regime, (ii) concentrazione tattica sugli asset vincenti quando l’evidenza è forte, (iii) de-risking tempestivo verso asset rifugio quando il contesto peggiora. Il risultato è un’alpha più stabile: il portafoglio tende a guadagnare di più nelle fasi favorevoli e a perdere meno nelle correzioni, consolidando la superiorità rispetto allo SPY e al 60/40.

Dopo l’elaborazione, le allocazioni vengono filtrate per renderle implementabili: si applicano soglie minime di posizione, si limita la frequenza di ribilanciamento e si incorporano costi reali (26% di capital gain tax e 0,3% di costi di transazione). Questo livello di filtraggio riduce il numero medio di riallocazioni a circa 7,7 cambi per anno.

Risultati principali

Le performance del modello sono riassunte nei seguenti grafici e tabelle.

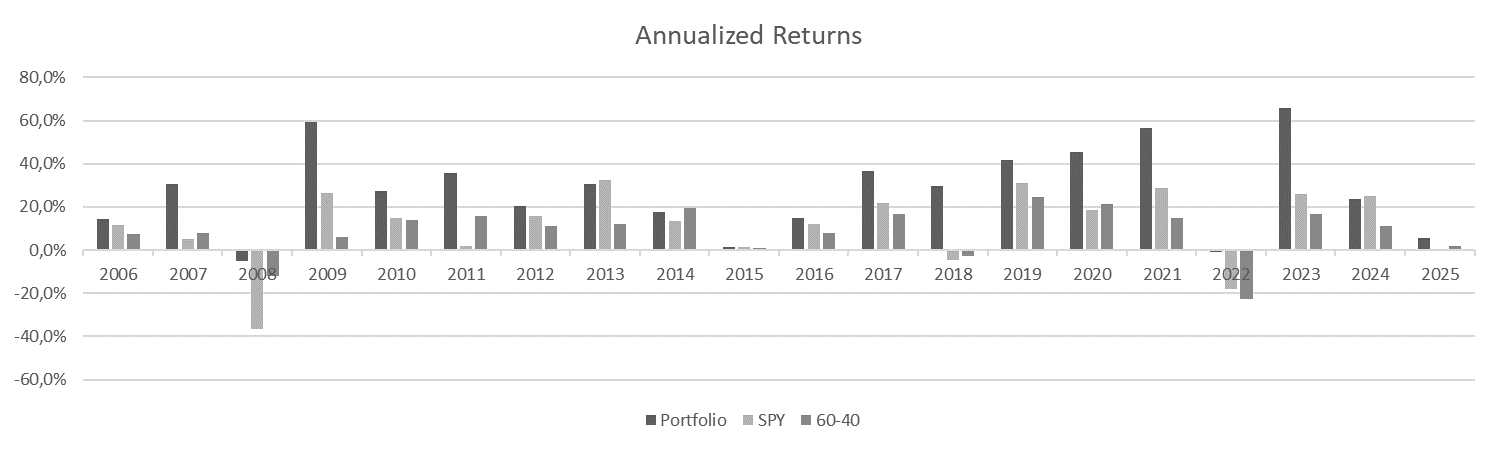

| 2016 | 2017 | 2018 | 2019 | 2020 | 2021 | 2022 | 2023 | 2024 | 2025 | |

|---|---|---|---|---|---|---|---|---|---|---|

| Portfolio | 14,7% | 36,6% | 29,8% | 41,6% | 45,4% | 56,4% | -0,8% | 65,8% | 23,4% | 5,6% |

| SPY | 12,0% | 21,7% | -4,6% | 31,2% | 18,3% | 28,7% | -18,2% | 26,2% | 24,9% | -0,2% |

| 60-40 | 8,1% | 16,8% | -2,9% | 24,7% | 21,5% | 14,8% | -22,8% | 16,9% | 10,9% | 1,9% |

Negli anni 2016–2025 (YTD) il grafico degli “Annualized Returns” mostra con chiarezza un vantaggio sistematico del portafoglio generato dal modello rispetto ai due riferimenti di mercato (SPY e 60/40). L’aspetto più rilevante non è solo l’entità dei picchi positivi, ma la capacità di mantenere performance robuste in contesti di mercato molto diversi, suggerendo un’allocazione dinamica che si adatta via via al regime prevalente.

Nei periodi di stress il modello ha attenuato le perdite o addirittura generato rendimenti positivi: nel 2018 chiude in forte rialzo (+29,8%) contro un mercato in calo (SPY –4,6%), mentre nel 2022 limita il danno a –0,8% a fronte di correzioni marcate sia per SPY (–18,2%) sia per il 60/40 (–22,8%). Questa tenuta nei drawdown è coerente con un processo che ribilancia in modo opportunistico, riducendo l’esposizione ai segmenti più vulnerabili quando la volatilità si concentra.

Nelle fasi espansive, il modello riesce ad amplificare l’upside: la sequenza 2019–2021 mostra extra-rendimenti significativi (fino al +56,4% nel 2021), e il 2023 rappresenta un altro esempio emblematico con +65,8% contro il +26,2% dello SPY. Anche quando il mercato corre molto, il portafoglio mantiene un differenziale favorevole nella maggior parte degli anni. Fa eccezione il 2024, dove il modello resta comunque su ottimi livelli (+23,4%) pur leggermente sotto SPY (+24,9%) e ben sopra il 60/40 (+10,9%). L’avvio del 2025 YTD conferma la resilienza (+5,6% vs –0,2% SPY e +1,9% 60/40).

(Nota: 2025 è fino a febbraio; le performance passate non garantiscono rendimenti futuri.)

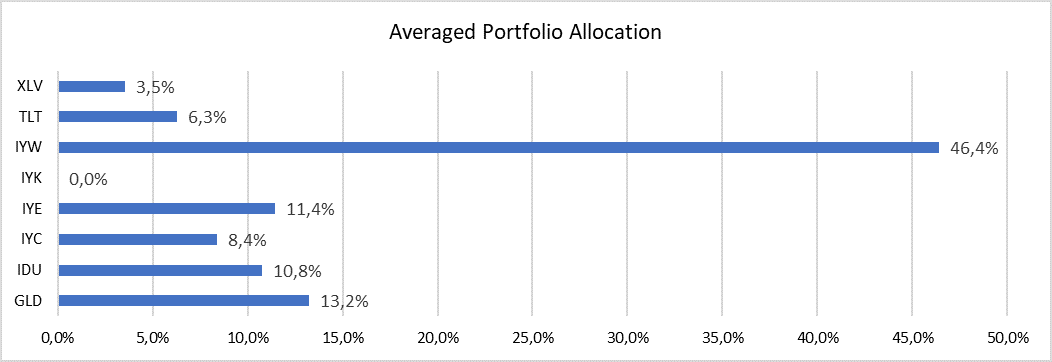

La composizione media del portafoglio evidenzia l’orientamento del modello: circa 46,4% in tecnologia (ETF IYW), 13,2% in oro (GLD), 11,4% in energia (IYE) e 10,8% in utilities (IDU). Le altre asset class hanno pesi minori: consumer discretionary 8,4% (IYC), sanità 3,5% (XLV), treasury a lunga scadenza 6,3% (TLT) e zero esposizione ai beni di consumo di base (IYK). Questa distribuzione riflette una preferenza per settori growth ma mantiene diversificazione su asset difensivi come l’oro e i bond statali.

Confronto con altre metodologie di Machine Learning

Metodi di ML tradizionali – come regressioni, alberi decisionali o reti Bayesiane – sono efficaci quando la dimensione dei dati è contenuta o i pattern sono relativamente semplici. Tuttavia, per catturare la non linearità e le relazioni sequenziali tipiche dei mercati finanziari, la letteratura dimostra che i modelli di DL – in particolare LSTM, CNN, modelli Seq2Seq e Generative Adversarial Networks – ottengono risultati migliori: ad esempio, l’LSTM supera di gran lunga l’ARIMA nel forecasting e tecniche come le CNN, originariamente sviluppate per immagini, forniscono previsioni più accurate sui dati finanziari rispetto ai metodi non neurali [4]. Inoltre, i modelli di DL possono elaborare contemporaneamente decine di indicatori tecnici, macroeconomici e di sentiment.

Il nostro modello possiede ulteriori caratteristiche distintive rispetto a molte applicazioni ML presenti sul mercato:

- Loss finanziaria personalizzata: mentre molti approcci ottimizzano semplicemente l’errore di previsione, il nostro modello massimizza il rapporto di Sharpe e il rendimento in eccesso, penalizzando la mancanza di diversificazione. Questo allineamento con gli obiettivi degli investitori è difficile da ottenere con tecniche ML tradizionali.

- Walk-forward optimization: la formazione su finestre scorrevoli riduce l’overfitting rispetto ai back-test statici. La letteratura accademica riconosce che l’addestramento su “dati futuri” introduce bias; il nostro approccio, addestrando soltanto sui dati disponibili al momento, minimizza questo rischio.

- Filtro operativo: l’integrazione dei costi reali e l’applicazione di soglie di ribilanciamento garantiscono che le strategie proposte siano implementabili e non restino simulazioni teoriche.

Ciononostante, il DL presenta limitazioni da non trascurare. Innanzitutto, richiede una quantità elevata di dati e notevoli risorse computazionali; inoltre, la complessità rende difficile spiegare perché il modello prenda determinate decisioni, un problema di interpretabilità già segnalato dagli studiosi [3]. L’adozione di tecniche di explainable AI e un robusto quadro di controllo (come raccomandato dal PRA [6]) sono quindi fondamentali per mitigare il rischio modello.

Conclusione

L’evoluzione della finanza quantitativa dimostra come l’Intelligenza Artificiale e in particolare il Deep Learning possano offrire opportunità significative per migliorare le decisioni di investimento. Le evidenze accademiche mostrano che i modelli DL superano i metodi tradizionali nelle previsioni e nell’allocazione del portafoglio [4], e gli organi istituzionali riconoscono il potenziale trasformativo ma richiamano all’attenzione sui rischi di concentrazione e sulla necessità di un’efficace governance [1]. Il modello qui presentato, con la sua architettura LSTM-CNN-Attention, la loss finanziaria personalizzata e il filtraggio operativo, rappresenta un esempio concreto di come il DL possa essere applicato in modo efficiente e responsabile alla gestione di portafogli multi-asset.

Per i consulenti finanziari, integrare questi strumenti significa non soltanto ottenere performance potenzialmente superiori, ma anche dotarsi di una visione olistica delle dinamiche di mercato. Nel raccomandare o utilizzare soluzioni basate su IA è tuttavia indispensabile mantenere un presidio di controllo e trasparenza, assicurandosi che gli algoritmi siano ben compresi, validati e allineati alle esigenze del cliente. Solo così si potranno cogliere appieno le opportunità del futuro rimanendo al contempo all’interno di un perimetro di rischio accettabile.

Riferimenti

- The rise of artificial intelligence: benefits and risks for financial stability — BCE. Link

- Enhancing portfolio management using artificial intelligence: literature review — PMC. Link

- (Interpretabilità) Ibidem, sezioni su explainability e black box. Link

- (Forecasting time-series con DL) Ibidem, sezioni su LSTM/GRU/CNN/Seq2Seq. Link

- DP5/22 — Artificial Intelligence and Machine Learning | Bank of England (PRA). Link

- (Governance ciclo di vita del modello) Ibidem — principi proposti dal PRA. Link